A cura di Vittorio Calaprice

L’Intelligenza Artificiale e la Cybersecurity sono due settori che influenzano oramai in maniera pervasiva ogni aspetto della vita umana.

La loro interconnessione è diventata un’area di interesse scientifico sempre più forte per i ricercatori ed una nuova area di collaborazione tra esperti provenienti da “campi diversi”.

Per offrire un quadro sistematico alla materia e studiare le intersezioni tra IA e cybersecurity, l’Agenzia europea per la sicurezza delle reti e dell’informazione (ENISA) ha pubblicato recentemente2 un documento – denominato “Artificial Intelligence and Cybersecurity Research” – che ha preso in considerazione le dimensioni operative dell’IA nei confronti della cybersecurity:

- l’uso dei sistemi di Intelligenza Artificiale come “servizi criminali” (ovvero una “IA per nuocere”);

- il supporto per la cybersecurity (ovvero una “IA per proteggere”).

Come è noto, l’Intelligenza Artificiale sta rivoluzionando il campo della Cybersecurity, migliorando notevolmente la rilevazione, la prevenzione e la risposta alle minacce. Gli algoritmi di machine learning (ML, apprendimento automatico) riescono ad analizzare enormi quantità di dati per identificare schemi e comportamenti insoliti che potrebbero indicare un attacco informatico.

I sistemi di IA possono infatti imparare rapidamente dagli incidenti passati, adattando e migliorando i loro meccanismi di difesa in tempo reale.

I sistemi di rilevamento delle minacce – gestiti dall’IA – sono in grado di monitorare agevolmente il traffico di rete, i comportamenti degli utenti e le attività delle applicazioni. Analizzando continuamente i dati, questi sistemi possono individuare anomalie che potrebbero sfuggire ai tradizionali approcci basati su regole.

Questa capacità di rilevare minacce precedentemente sconosciute è cruciale in un panorama dei rischi in evoluzione in cui gli aggressori cambiano costantemente tattiche.

Ad esempio, le istituzioni finanziarie e le piattaforme di e-commerce sfruttano l’IA per combattere le frodi. I modelli di apprendimento automatico imparano a distinguere tra transazioni legittime e fraudolente basandosi sui dati storici. Questi modelli possono identificare schemi sospetti, come comportamenti di acquisto insoliti, contribuendo a prevenire l’accesso non autorizzato e le perdite finanziarie.

La capacità dell’IA di elaborare e analizzare grandi quantità di dati può aiutare i professionisti della Cybersecurity a rimanere un passo avanti rispetto ai criminali informatici.

Al contrario, le stesse funzionalità di intelligenza artificiale possono ugualmente potenziare l’arsenale in mano ai criminali informatici. Si pensi a bot basati sull’intelligenza artificiale che possono lanciare attacchi informatici sofisticati e persistenti: l’IA viene utilizzata per creare attacchi di phishing più efficaci e sofisticati personalizzando le e-mail attraverso dettagli personali raccolti dai social media.

Inoltre, i deepfake, generati dall’intelligenza artificiale, possono essere utilizzati per commettere frodi o spingere notizie false.

Gli stessi sistemi di intelligenza artificiale possono essere bersaglio di attacchi informatici. Gli aggressori possono manipolare i dati inseriti in un sistema di intelligenza artificiale (avvelenamento dei dati) per influenzarne i risultati. Il rischio di attacchi che comportano l’alterazione dei dati di input per ingannare il sistema di intelligenza artificiale è esponenzialmente cresciuto.

Il documento dell’ENISA su “Intelligenza artificiale e ricerca sulla cybersecurity” parte da queste considerazioni per presentare una panoramica sui risultati di 44 progetti di ricerca finanziati dall’Unione europea a partire il 2014.

Lo studio si concentra sulla necessità di un rafforzamento della ricerca e dello sviluppo nel campo dell’IA e della Cybersecurity, favorendo quindi la condivisione dell’intelligence sulle minacce.

Il tema dello sviluppo di competenze qualificate nonché la promozione della cooperazione tra i vari stakeholders appaiono infatti obiettivi strategici da perseguire.

Il documento ENISA evidenzia inoltre l’importanza di stabilire standard giuridici per l’uso dell’IA nella cybersecurity in modo che sia mantenuto un buon equilibrio tra la necessità dell’IA di accedere ai dati e i diritti alla privacy degli individui.

Lo studio formula alcune raccomandazioni per affrontare le sfide attraverso la ricerca scientifica e individua delle aree chiave per guidare gli esperti che guidano la ricerca e lo sviluppo sull’intelligenza artificiale e la sicurezza informatica.

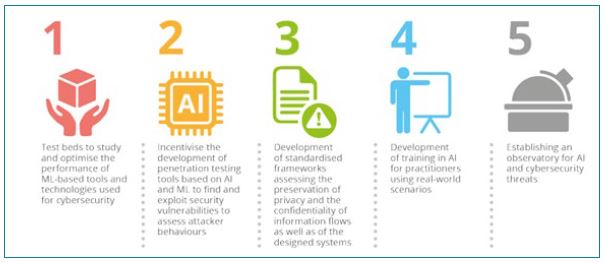

In sintesi, secondo l’ENISA, sono cinque aree di ricerca che stanno offrendo interessanti risultati e per le quali focalizzarsi nel futuro:

- simulazioni e testing per ottimizzare le tecnologie di machine learning (ML);

- sviluppo di strumenti di “penetration test” basati su IA e ML;

- sviluppo di quadri standardizzati che valutino la tutela della privacy;

- formazione sull’intelligenza artificiale per professionisti che lavorano nella cybersecurity;

- creazione di un osservatorio per le minacce all’intelligenza artificiale e alla sicurezza informatica.

L’intersezione tra IA e Cybersecurity presenta un panorama complesso pieno di opportunità e rischi. Il documento dell’ENISA serve a far luce su questo panorama e a orientare la via da seguire.

Man mano che l’IA continuerà a crescere ed evolversi anche le strategie di Cybersecurity dovranno crescere, guidate da ricerche approfondite e in evoluzione con il lavoro dell’ENISA.

Rimane infine aperta la questione fondamentale alla base di questo studio, se gli investimenti nella ricerca e nell’innovazione in materia di cybersecurity sull’IA abbiano consentito all’Europa di compiere progressi in questo settore: le prime indicazioni mostrano che c’è ancora molto lavoro da fare, ma che la strada è stata oramai intrapresa!

*le opinioni espresse nell’articolo sono dell’autore e non rappresentano necessariamente la posizione ufficiale della Commissione europea

Note:

2. Sviluppato dal Consorzio Interuniversitario Nazionale per l’Informatica (CINI) e dal Centro di Ricerca di Cyber Intelligence and Information Security (CIS) Sapienza, con il supporto del Dipartimento delle Informazioni per la Sicurezza (DIS) della Presidenza del Consiglio dei ministri e in collaborazione, tra l’altro, con il Garante per la protezione dei dati personali (GPDP).